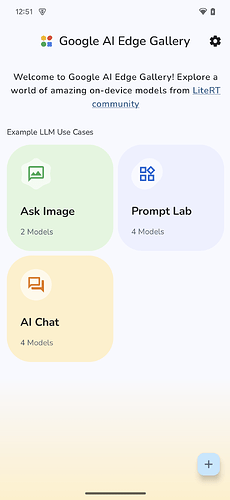

Google AI Edge Gallery:移动端本地运行AI模型指南

一、应用概述

Google AI Edge Gallery允许用户在不联网的情况下,在移动设备上运行AI模型。一旦模型加载完成,所有数据处理均在本地完成,无需持续网络连接。

二、特点

1. 完全离线运行

所有AI处理均在设备本地完成,模型下载后无需网络连接。

2. 模型选择与管理

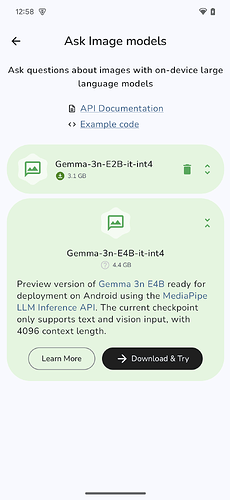

用户可以从Hugging Face下载并切换不同模型,比较性能表现。部分模型(如Gemma 3)需要登录Hugging Face账户并同意特定许可条款。

3. 图像问答(Ask Image)

用户可以上传图片并向AI提问,获取图像描述、问题解答或物体识别结果。

4. 提示实验室(Prompt Lab)

支持单轮交互,可用于摘要、改写、生成代码或自由形式的提示,探索大语言模型的单轮使用场景。

5. 智能对话(AI Chat)

支持多轮对话,可进行连续的问答交流。

6. 性能统计

提供实时性能指标,包括:

- 首个词元时间(TTFT)

- 解码速度

- 延迟数据

7. 本地模型导入

支持导入自定义的LiteRT兼容模型(.task格式)。

8. 开发者资源

提供模型卡片和源代码的快速链接。

三、安装与使用

安装方法

-

直接安装(最简单):

- 从GitHub发布页下载最新APK

- 在设备文件管理器中找到并点击.apk文件

- 允许来自"未知来源"的安装(通常在设备安全设置中)

- 确认安装

-

通过ADB安装:

- 启用开发者选项和USB调试

- 使用命令:

adb push /path/to/model.task /sdcard/Download/

模型下载与使用

- 选择功能后,系统会列出兼容该任务的模型

- 若模型未下载,点击展开模型项后会显示"下载"按钮

- 下载完成后,按钮变为"试用",即可使用该模型

- 下载过程在后台进行,可以切换应用或锁定设备

导入本地模型

- 将.task格式模型文件推送到设备的Download文件夹

- 打开应用,点击主屏幕右下角的"+"图标

- 在文件选择器中选择已推送的.task文件

- 在"导入模型"对话框中配置默认参数,对于多模态模型可勾选"支持图像"

- 点击"导入"完成操作

四、技术特点

支持的模型格式

应用支持LiteRT优化的.task格式模型文件,这种格式专为移动设备优化,能够在资源受限的环境中高效运行。

性能表现

根据官方数据,在Pixel 8 Pro上运行2B参数的Gemma模型时,首字延迟(TTFT)仅需1.3秒,展示了在移动设备上运行大型AI模型的可行性。

硬件要求

- 兼容Android 10及以上系统

- 推荐使用具有NPU/GPU的设备以获得更好性能

- 建议设备:搭载Tensor G3、Snapdragon 8 Gen2及以上芯片的设备

五、安全与隐私

- 所有数据处理均在设备本地完成

- 下载模型时需要临时网络连接

- 使用模型时不会将用户数据发送到云端

- 开源协议:Apache 2.0

六、常见问题

模型下载失败

可能原因:

- 网络连接不稳定

- 存储空间不足

- 模型需要Hugging Face账户授权

解决方案:

- 检查网络连接

- 清理设备存储空间

- 登录Hugging Face账户并接受许可条款

模型运行缓慢

可能原因:

- 设备硬件限制

- 后台应用占用资源

- 模型参数量过大

优化建议:

- 关闭后台应用

- 尝试使用参数量较小的模型

- 优先使用GPU/NPU加速

结语

Google AI Edge Gallery 是一个集成的手机自行部署ai的软件,适合小白

温馨提示:手机不好的建议不要跑高配模型